昨天,我们在本地部署了最近大火的 DeepSeek 模型。(参考:)

当时我搭配大模型使用的聊天客户端是 ChatX,但用下来发现,ChatX 对输出的内容显示不是太好,看得我眼花。于是我继续寻找,发现了一款更好用的客户端软件:Chatbox。

Chatbox 的官网如下:

它是一款开源的 AI 客户端,这是它的 GitHub 仓库地址:

这款客户端支持各种主流模型的 API 接入,淘宝买的中转 API 也可以用,当然也支持我们用 Ollama 在本地部署的 DeepSeek。

而且,它有自己的付费 AI 服务,可以使用各种主流的大模型,需要按月付费订阅。

当然,我们已经在本地部署大模型了,就不需要去买它家的 AI 服务了,除此之外使用其他所有功能都是免费的。

这款客户端基本全平台支持,包括 Windows、macOS、Linux、iOS、Android。

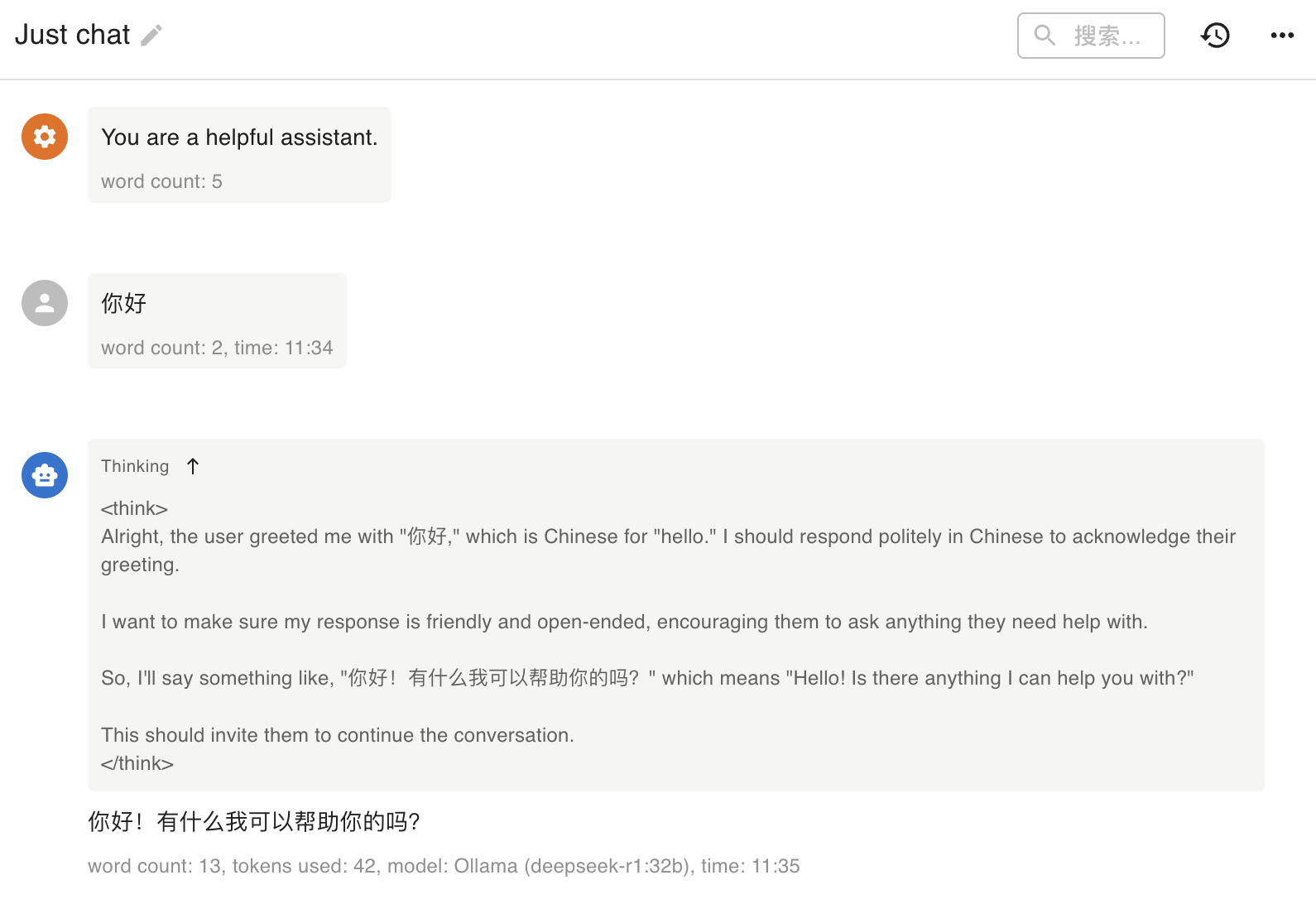

我试了一下,配置非常简单,「模型提供方」选择「Ollama API」,模型下拉框里会自动跳出来你运行的模型,选中保存即可。

它支持 DeepSeek 的思考内容单独显示,还可以折叠,不像 ChatX 那样全混在一起。

同时,它也支持 LaTeX 和 Markdown 渲染,显示数学公式没啥问题。

当然,代码显示也没问题。

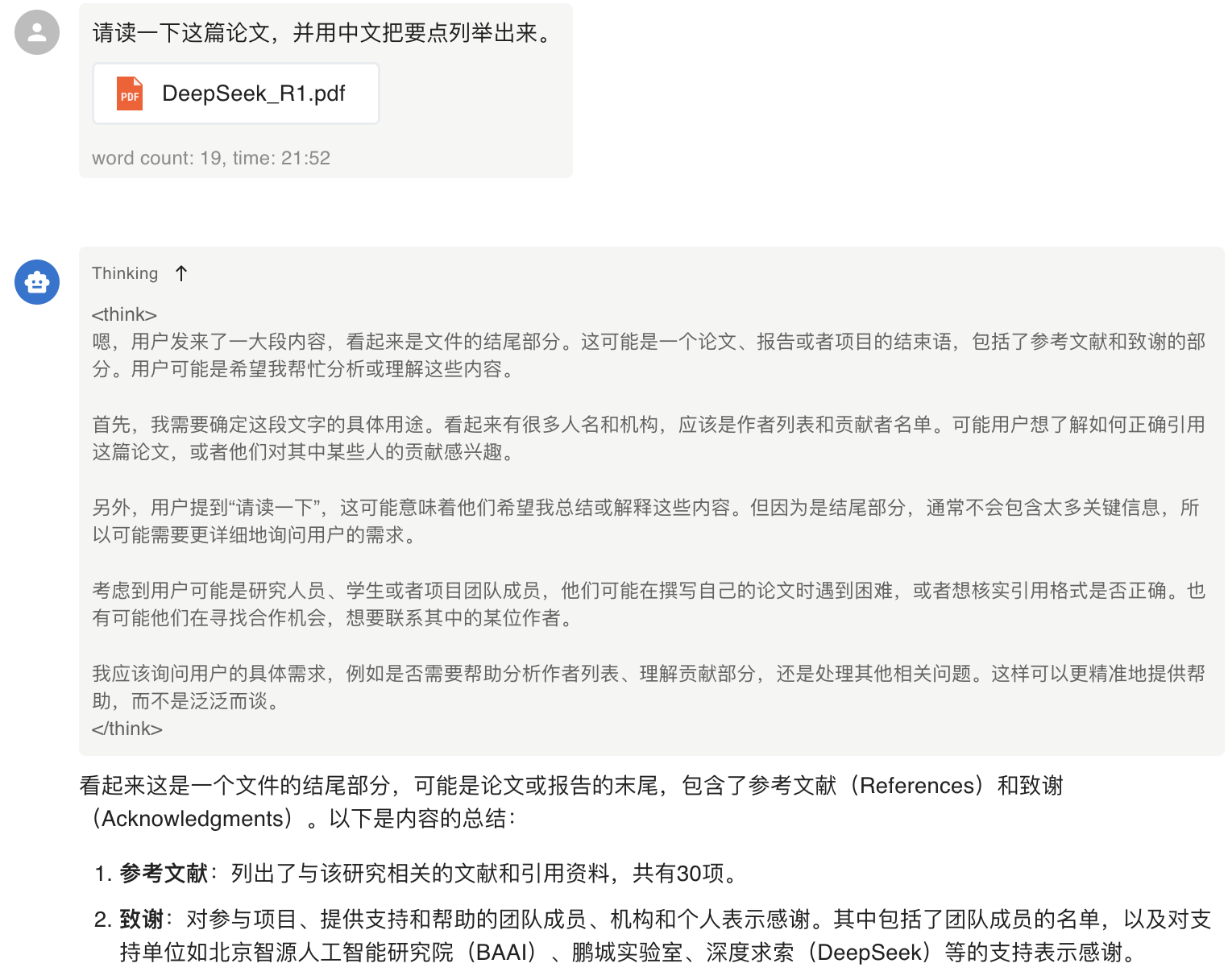

不过,我用客户端让 AI 阅读 PDF 文档时就遇到了问题,我让它读 R1 的论文,结果它只读到了结尾的参考文献和致谢……

我怀疑是客户端在本地 PDF 转文本时出的 bug,导致 AI 大模型无法获取到完整的内容。

不过,这也是小问题,未来应该能够解决。